L’informaticien Christopher Kanan propose une introduction à l’IA générative, aux grands modèles de langage et à l’utilisation responsable de l’intelligence artificielle. Il s’avère que la formation des systèmes d’intelligence artificielle n’est pas sans rappeler l’éducation d’un enfant. C’est pourquoi certains chercheurs en intelligence artificielle ont commencé à imiter la façon dont les enfants acquièrent naturellement des connaissances et apprennent à connaître le monde qui les entoure : par l’exploration, la curiosité, l’apprentissage progressif et le renforcement positif.

« De nombreux problèmes posés aujourd’hui par les algorithmes d’IA pourraient être résolus en s’inspirant des neurosciences et du développement de l’enfant », explique Christopher Kanan, professeur associé au département d’informatique de l’université de Rochester et expert en intelligence artificielle, en apprentissage continu, en vision et en algorithmes inspirés par le cerveau.

Bien entendu, le fait d’apprendre et d’être capable de raisonner comme un humain, mais plus rapidement et peut-être mieux, soulève des questions sur la meilleure façon de protéger les humains contre les systèmes d’IA en constante évolution. C’est pourquoi M. Kanan estime que tous les systèmes d’IA doivent être dotés de garde-fous, mais qu’il est trop tard pour le faire à la toute fin du développement. « Ce ne devrait pas être la dernière étape, sinon nous risquons de libérer un monstre. »

Questions et réponses avec Christopher Kanan

Qu’est-ce que l’intelligence artificielle générale et en quoi diffère-t-elle des autres types d’IA ?

L’intelligence artificielle générale (AGI) vise à construire des systèmes capables de comprendre, de raisonner et d’apprendre comme le font les humains. L’AGI est plus avancée que l’intelligence artificielle étroite (ANI), qui est conçue pour des tâches spécifiques, mais qui n’a pas encore été réalisée.

Kanan : L’IA consiste à créer des systèmes informatiques capables d’accomplir des tâches qui requièrent généralement l’intelligence humaine, telles que la perception, le raisonnement, la prise de décision et la résolution de problèmes. Traditionnellement, une grande partie de la recherche en IA s’est concentrée sur la construction de systèmes conçus pour des tâches spécifiques, appelés intelligence artificielle étroite (IAO). Il s’agit par exemple de systèmes de reconnaissance d’images, d’assistants vocaux ou de jeux stratégiques, tous capables d’accomplir leurs tâches de manière exceptionnelle, souvent en surpassant les humains. Il y a ensuite l’intelligence artificielle générale (AGI), qui vise à construire des systèmes capables de comprendre, de raisonner et d’apprendre dans un large éventail de tâches, comme le font les humains.

La réalisation de l’AGI reste un objectif majeur de la recherche en IA, mais n’a pas encore été accomplie. Au-delà de l’AGI se trouve la superintelligence artificielle (ASI), une forme d’IA dépassant largement l’intelligence humaine dans pratiquement tous les domaines, qui reste spéculative et actuellement confinée à la science-fiction. Dans mon laboratoire, nous nous intéressons particulièrement à la possibilité de nous rapprocher de l’intelligence générale artificielle en nous inspirant des neurosciences et du développement de l’enfant, afin de permettre aux systèmes d’IA d’apprendre et de s’adapter en permanence, un peu comme le font les enfants humains.

Comment l’IA peut-elle « apprendre » ?

L’IA repose sur des réseaux neuronaux profonds formés à partir de grandes quantités de données.

Kanan : L’ANI réussit grâce à l’apprentissage profond, qui, depuis 2014 environ, est utilisé pour former ces systèmes à apprendre à partir de grandes quantités de données annotées par des humains. L’apprentissage profond consiste à former de grands réseaux neuronaux artificiels composés de nombreuses couches interconnectées. Aujourd’hui, l’apprentissage profond est à la base de la plupart des applications modernes de l’IA, de la vision artificielle et du traitement du langage naturel à la robotique et à la recherche biomédicale. Ces systèmes excellent dans des tâches telles que la reconnaissance d’images, la traduction de langues, les jeux complexes tels que Go et les échecs, et la génération de textes, d’images et même de codes.

Un grand modèle de langage (LLM) comme le GPT-4 de l’OpenAI est formé sur d’énormes quantités de texte à l’aide de l’apprentissage auto-supervisé. Cela signifie que le modèle apprend en prédisant le mot ou la phrase suivante à partir d’un texte existant, sans orientation ou étiquette humaine explicite. Ces modèles sont généralement entraînés sur des trillions de mots, c’est-à-dire la totalité des écrits humains disponibles en ligne, y compris les livres, les articles et les sites web. Pour donner un ordre d’idée, si un être humain tentait de lire tout ce texte, il lui faudrait des dizaines de milliers de vies.

Après cette formation initiale approfondie, le modèle est soumis à un réglage fin supervisé, où les humains fournissent des exemples de résultats préférés, guidant le modèle vers la génération de réponses qui s’alignent étroitement sur les préférences humaines. Enfin, des techniques telles que l’apprentissage par renforcement avec retour d’information humain (RLHF) sont appliquées pour façonner le comportement du modèle en définissant des limites acceptables pour ce qu’il peut ou ne peut pas générer.

En quoi les IA sont-elles vraiment douées ?

L’IA excelle dans les langues humaines et obtient de très bons résultats à des tests difficiles.

Kanan : Elles sont excellentes dans les tâches impliquant des langues humaines, notamment la traduction, la rédaction d’essais, l’édition de textes, l’apport de commentaires et la fonction de tuteur d’écriture personnalisé.

Ils peuvent réussir des tests standardisés. Par exemple, le GPT-4 d’OpenAI obtient des scores de premier ordre à des tests très difficiles tels que l’examen du barreau (90e percentile), le LSAT (88e percentile), le GRE quantitatif (80e percentile), le GRE verbal (99e percentile), l’USMLE et plusieurs tests d’Advanced Placement. Ils excellent même dans les examens de mathématiques de niveau doctorat. Étonnamment, des études ont montré qu’ils ont une intelligence émotionnelle supérieure à celle des humains.

Au-delà des tests, les LLM peuvent jouer le rôle de cochercheurs, en aidant les chercheurs à formuler de nouvelles hypothèses, à rédiger des propositions de recherche et à synthétiser une littérature scientifique complexe. Ils sont de plus en plus intégrés dans des systèmes multimodaux conçus pour des tâches de vision et de langage, la robotique et la planification d’actions dans le monde réel.

Quelles sont les limites actuelles des outils d’IA générative ?

Les itérations actuelles de l’IA n’ont pas une conscience de soi et des capacités de raisonnement semblables à celles de l’homme.

Kanan : Les LLM peuvent encore « halluciner », ce qui signifie qu’ils produisent en toute confiance des informations plausibles mais incorrectes. Leurs capacités de raisonnement et de planification, bien qu’elles s’améliorent rapidement, sont encore limitées par rapport à la flexibilité et à la profondeur du niveau humain. Ils n’apprennent pas continuellement par l’expérience ; leurs connaissances sont en fait figées après l’entraînement, ce qui signifie qu’ils n’ont pas conscience des développements récents ou des changements en cours dans le monde.

Les systèmes d’IA générative actuels manquent également de métacognition, ce qui signifie qu’ils ne savent généralement pas ce qu’ils ne savent pas et qu’ils posent rarement des questions de clarification lorsqu’ils sont confrontés à l’incertitude ou à des messages ambigus. Cette absence de conscience de soi limite leur efficacité dans les interactions avec le monde réel.

L’être humain excelle dans l’apprentissage continu, où les compétences acquises précocement servent de base à des capacités de plus en plus complexes. Par exemple, les nourrissons doivent d’abord maîtriser le contrôle moteur de base avant de pouvoir marcher, courir ou même faire de la gymnastique. Les gestionnaires de l’apprentissage tout au long de la vie d’aujourd’hui ne démontrent pas et ne sont pas évalués de manière efficace sur ce type d’apprentissage cumulatif et de transfert vers l’avant. L’un des principaux objectifs des recherches de mon laboratoire est de remédier à cette limitation.

Quels sont les principaux défis et risques posés par l’IA ?

L’IA remodèle la main-d’œuvre et le débat sur la réglementation.

Kanan : L’IA générative transforme déjà considérablement le monde du travail. Elle est particulièrement perturbatrice pour les cols blancs – des postes qui exigent traditionnellement une formation ou une expertise spécialisée – parce que les copilotes de l’IA permettent aux travailleurs individuels d’augmenter considérablement leur productivité ; ils peuvent faire en sorte que les novices travaillent à un niveau plus proche de celui des experts. Cette productivité accrue signifie que les entreprises pourraient fonctionner efficacement avec beaucoup moins d’employés, ce qui soulève la possibilité d’une réduction à grande échelle des postes de cols blancs dans de nombreux secteurs d’activité. En revanche, les emplois qui requièrent de la dextérité, de la créativité, du leadership et une interaction physique directe, tels que les métiers spécialisés, les postes dans le secteur de la santé impliquant des soins directs aux patients ou l’artisanat, ne seront probablement pas remplacés par l’IA dans un avenir proche.

Si des scénarios tels que le célèbre « Paperclip Maximizer » de Nick Bostrom, dans lequel l’AGI détruit l’humanité par inadvertance, sont couramment évoqués, je pense que le risque immédiat le plus important concerne les humains qui pourraient délibérément utiliser l’IA avancée à des fins catastrophiques. Les efforts doivent se concentrer sur la coopération internationale, le développement responsable et l’investissement dans la recherche universitaire sur la sécurité de l’IA.

Pour garantir que l’IA est développée et utilisée en toute sécurité, nous avons besoin d’une réglementation concernant des applications spécifiques. Il est intéressant de noter que les personnes qui réclament aujourd’hui une réglementation gouvernementale sont celles qui dirigent les entreprises d’IA. Mais personnellement, je m’inquiète aussi d’une réglementation qui pourrait éliminer les efforts en matière d’IA à source ouverte, étouffer l’innovation et concentrer les avantages de l’IA entre les mains d’un petit nombre.

Quelles sont les chances de parvenir à l’intelligence générale artificielle (AGI) ?

De nombreux chercheurs en IA s’accordent à dire que l’AGI est possible, mais que les LLM actuels sont trop limités.

Kanan : Les trois « parrains » de l’IA moderne et lauréats du prix Turing – Joshua Bengio, Geoffrey Hinton et Yann LeCun – sont tous d’accord pour dire que l’AGI est possible. Récemment, Bengio et Hinton ont exprimé de vives inquiétudes, estimant que l’AGI pourrait représenter un risque existentiel pour l’humanité. Néanmoins, je ne pense pas qu’aucun d’entre eux – ni moi-même – ne croyions que les architectures LLM d’aujourd’hui suffiront à réaliser une véritable AGI.

Les LLM raisonnent intrinsèquement à l’aide du langage, alors que pour les humains, le langage sert avant tout de moyen de communication plutôt que de support principal de la pensée elle-même. Cette dépendance à l’égard du langage limite intrinsèquement la capacité des LLM à s’engager dans un raisonnement abstrait ou dans la visualisation, limitant ainsi leur potentiel pour une intelligence plus large, semblable à celle de l’homme.

* CHRISTOPHER KANAN

Christopher Kanan est professeur agrégé d’informatique à l’université de Rochester, avec des nominations secondaires au département des sciences du cerveau et de la cognition, à l’institut Goergen pour la science des données et l’intelligence artificielle, et au centre pour la science visuelle. Il est expert en intelligence artificielle, en apprentissage continu, en vision et en algorithmes inspirés par le cerveau.

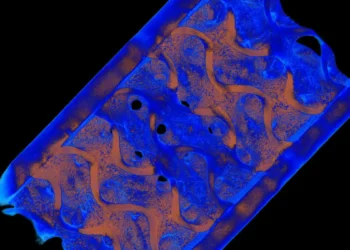

Légende illustration : L’effet Pinocchio : « Les LLM peuvent encore « halluciner », ce qui signifie qu’ils produisent en toute confiance des informations plausibles mais incorrectes », explique M. Kanan. (Illustration de l’Université de Rochester / Sandra Knispel utilisant ChatGPT d’OpenAI)