Alors que l’industrie technologique semble atteindre les limites de la loi de Moore, une entreprise finlandaise des plus audacieuses propose une solution qui pourrait bien relancer la course à la puissance de calcul en multipliant par 100 les performances des processeurs d’unités centrales dans le traitement des données.

Depuis quelques années, les puces accélératrices d’intelligence artificielle ont énormément capté l’attention des technophiles grâce notamment à la société américaine Nvidia pour ne citer que la plus célèbre. A contrario, les processeurs d’unités centrales (CPU) ont été progressivement relégués au second plan.

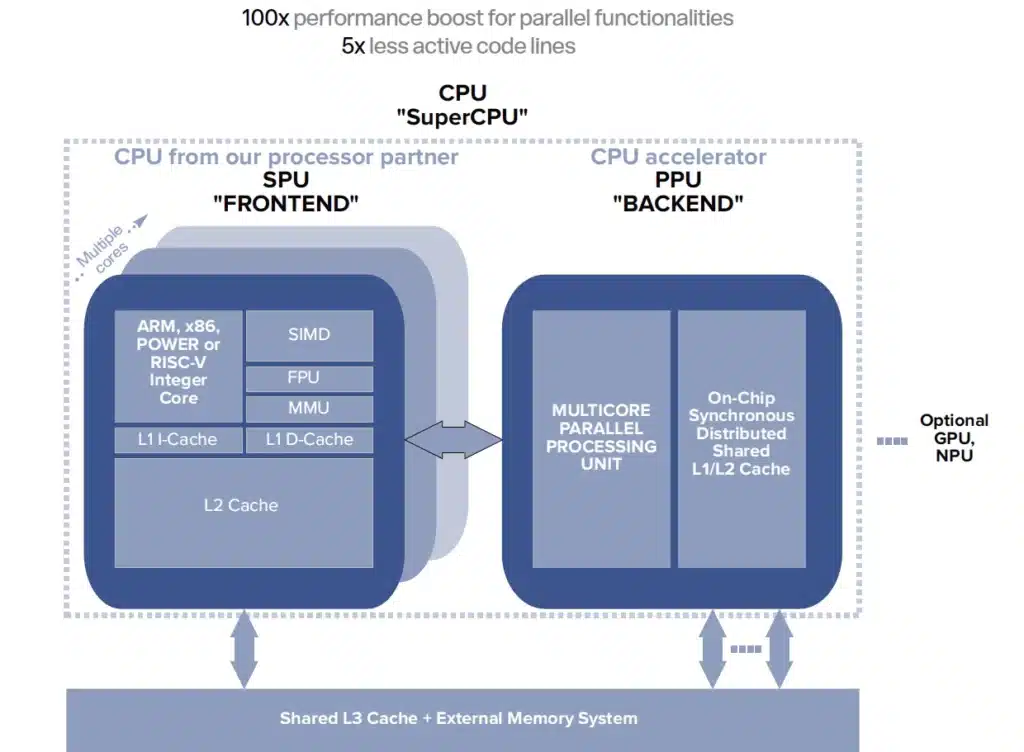

La Start-up Flow Computing, avec sa technologie d’Unité de Traitement Parallèle (PPU), ambitionne de changer la donne et de transformer radicalement l’architecture des CPU pour les replacer justement au cœur des systèmes informatiques. Elle s’attaque en effet au défi de l’optimisation des processeurs sous un angle totalement nouveau.

Pour faire court, le PPU fonctionne en tandem avec le processeur central et est en mesure de traiter simultanément de nombreuses tâches, offrant des avantages dans divers domaines comme l’intelligence artificielle, le calcul scientifique et la réalité virtuelle.

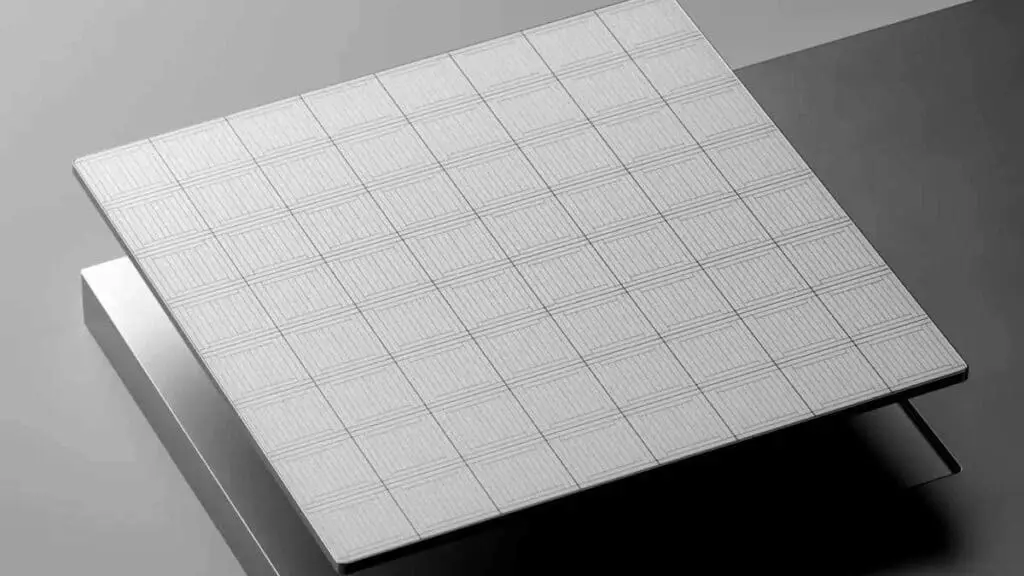

Un aperçu de l’unité de traitement parallèle (PPU)

L’approche de Flow Computing repose donc sur l’introduction d’une unité de traitement parallèle (PPU). Au lieu d’intégrer 16 cœurs CPU identiques dans un ordinateur portable, les fabricants pourraient opter pour une configuration combinant 4 cœurs CPU standard et 64 cœurs PPU. Cette configuration permettrait d’atteindre des performances jusqu’à 100 fois supérieures, tout en conservant la même empreinte matérielle.

La PPU offre ainsi une accélération significative pour les tâches parallélisables, comblant ainsi l’écart entre les CPU traditionnels et les GPU spécialisés. Le professeur Jörg Keller, expert en parallélisme à l’Université de Hagen en Allemagne, a souligné l’importance de cette innovation : « Cela change la donne pour les charges de travail plus petites, ce qui signifie que la parallélisation peut être appliquée à davantage d’endroits dans le code. »

Une architecture conçue pour la polyvalence

Martti Forsell, directeur technique et co-fondateur de Flow Computing, a précisé que les tâches informatiques se divisent généralement en deux catégories : séquentielles et parallèles. L’architecture proposée par son entreprise vise à optimiser le traitement des deux types de tâches au sein d’un même système. Et d’ajouter : « Lorsqu’une charge de travail séquentielle fait partie du code, la partie CPU l’exécutera. Et lorsqu’il s’agit de parties parallèles, le CPU les assignera à la PPU. Nous obtenons ainsi le meilleur des deux mondes. »

L’Unité de Traitement Parallèle (PPU) est un composant électronique conçu pour fonctionner aux côtés du processeur central (CPU) d’un ordinateur. Sa particularité réside dans sa capacité à traiter simultanément de nombreuses tâches, là où un processeur traditionnel les exécute généralement les unes après les autres.

Le PPU se distingue par sa flexibilité. Comme l’explique un porte-parole de Flow Computing : « Notre conception paramétrique permet une personnalisation étendue, y compris le nombre de cœurs PPU, la variété et le nombre d’unités fonctionnelles, et la taille des ressources de mémoire sur puce. »

Cette adaptabilité permet au PPU de s’ajuster à différents besoins :

• Le nombre de cœurs de calcul peut varier de 4 à 256 ou plus

• Les types d’unités de calcul (arithmétique, à virgule flottante, etc.) sont adaptables

• La taille de la mémoire intégrée est ajustable

Les avantages du PPU par rapport aux processeurs classiques

L’équipe de Flow Computing a identifié quatre exigences fondamentales pour une architecture informatique optimisée pour le parallélisme : la tolérance à la latence mémoire, une bande passante suffisante pour la communication entre les threads, une synchronisation efficace et un parallélisme de bas niveau.

Pour répondre à ces exigences, l’entreprise a élaboré une architecture entièrement nouvelle, spécifiquement adaptée au calcul parallèle. Par ailleurs, le PPU apporte trois améliorations majeures par rapport aux processeurs classiques :

1. Réduction des temps d’attente

Dans un processeur classique, l’accès à la mémoire peut ralentir l’exécution des tâches. Le PPU résout ce problème en exécutant d’autres tâches pendant les accès mémoire, évitant ainsi les temps morts.

2. Meilleure synchronisation

Les processeurs multi-cœurs actuels perdent du temps à synchroniser leurs différentes unités. Le PPU réduit considérablement ce temps de synchronisation, permettant une exécution plus fluide des tâches parallèles.

3. Exécution optimisée des instructions

Le PPU organise ses unités de calcul en chaîne, permettant à chaque unité d’utiliser directement les résultats de l’unité précédente. Cette organisation élimine les ralentissements liés aux dépendances entre instructions, fréquents dans les processeurs classiques.

Des résultats encourageants

Les premiers tests réalisés par Flow Computing ont révélé des résultats encourageants. Martti Forsell a ajouté : « Une amélioration jusqu’à 100 fois supérieure a été atteinte dans nos comparaisons de performances préliminaires, en supposant qu’il y aurait une implémentation en silicium d’un Flow PPU fonctionnant à la même vitesse que l’un des processeurs commerciaux comparés et utilisant notre microarchitecture. »

L’équipe développe actuellement un compilateur pour leur PPU et recherche des partenaires dans le domaine de la production de CPU. Leur technologie peut être implémentée avec n’importe quelle architecture de jeu d’instructions, offrant ainsi un potentiel d’amélioration pour tous les types de CPU existants.

Le professeur Keller a conclu en soulignant : « Le moment est vraiment venu pour cette technologie d’arriver sur le marché. Nous avons maintenant la nécessité d’un calcul économe en énergie dans les appareils mobiles, et en même temps, nous avons besoin de performances de calcul élevées.

Applications concrètes pour les utilisateurs

L’intégration du PPU dans nos appareils électroniques quotidiens pourrait transformer radicalement leurs capacités.

Les smartphones gagneraient en puissance, permettant l’exécution locale d’applications d’intelligence artificielle avancées sans dépendre de serveurs distants. Dans le domaine de la réalité virtuelle, les casques offriraient des expériences plus immersives grâce à des environnements plus réalistes et réactifs. Les ordinateurs personnels verraient leurs performances décuplées, accélérant considérablement des tâches complexes comme l’édition vidéo ou la modélisation 3D. Enfin, la sécurité des voitures autonomes serait renforcée, le traitement ultra-rapide des données des capteurs permettant une réaction quasi instantanée face aux dangers potentiels.

« Flow Computing développe un outil d’intelligence artificielle pour aider les développeurs d’applications et de logiciels à identifier les parties parallèles du code et à proposer des méthodes pour les optimiser afin d’obtenir des performances maximales. » a précisé un représentant de Flow Computing.

Un impact sur différents secteurs

Le PPU pourrait transformer de nombreux domaines grâce à ses capacités de calcul avancées. Dans le secteur de l’intelligence artificielle, l’accélération des calculs permettrait d’entraîner des modèles plus rapidement et à moindre coût, ouvrant la voie à des innovations plus fréquentes. Pour le calcul scientifique, les simulations numériques complexes, essentielles en météorologie ou en physique des particules, bénéficieraient d’une exécution nettement plus rapide, accélérant potentiellement les découvertes.

Dans le domaine de la défense, le traitement ultra-rapide des données offrirait un avantage stratégique crucial pour les systèmes militaires modernes, améliorant la prise de décision et la réactivité opérationnelle.

Google a récemment souligné l’importance de telles avancées lors de l’annonce de son premier processeur basé sur l’Arm en avril 024 : « Alors que nos investissements dans les accélérateurs de calcul ont transformé les capacités de nos clients, le calcul à usage général est et restera une partie critique des charges de travail de nos clients. L’analyse, la recherche d’informations, la formation et le service ML nécessitent tous une énorme puissance de calcul. Les clients et les utilisateurs qui souhaitent maximiser les performances, réduire les coûts d’infrastructure et atteindre les objectifs de durabilité ont constaté que le taux d’amélioration des processeurs a récemment ralenti. La loi d’Amdahl suggère qu’au fur et à mesure que les accélérateurs s’améliorent, le calcul à usage général dominera le coût et limitera la capacité de notre infrastructure, à moins que nous ne fassions des investissements proportionnels pour suivre le rythme. »

Si la technologie PPU de Flow Computing tient ses promesses, elle pourrait marquer le début d’une nouvelle ère dans l’informatique. Les appareils électroniques que nous utilisons quotidiennement pourraient devenir considérablement plus puissants, avec à la clé de nouvelles applications et innovations.

Un mot de Jörg Keller sur la technologie PPU

Le professeur Jörg Keller présente le concept de l’unité de traitement parallèle (PPU) de Flow Computing et explique en quoi elle diffère des processeurs multicœurs traditionnels. Le professeur Keller souligne les limites des processeurs actuels dotés de cœurs indépendants et la surcharge qu’ils subissent lors de l’exécution d’un code parallélisable.

Le PPU répond à ces limitations en disposant d’un ensemble de cœurs qui travaillent à l’unisson, ce qui réduit considérablement les frais généraux et permet une parallélisation efficace. En outre, les cœurs PPU sont plus petits et consomment moins d’énergie que les cœurs CPU traditionnels, ce qui renforce encore leur attrait.

Antti MÄKELÄ : Aujourd’hui, nous allons nous plonger dans la technologie PPU de Flow Computing. Jörg Keller, professeur à la faculté de mathématiques et d’informatique de l’université Fern à Hagen, se joint à nous. Le professeur Keller a procédé à la vérification technique de l’unité de traitement parallèle PPU de Flow.

Jörg KELLER : Aujourd’hui, nous avons des processeurs multi-cœurs. Il s’agit de processeurs dotés d’un plus grand nombre de cœurs afin d’augmenter les performances de calcul. Depuis un certain temps, ces cœurs de calcul sont tous identiques.

JK : Il y a quelque temps, les fabricants ont commencé à introduire des processeurs avec différents types de cœurs, comme la technologie « big little » d’Arm. Mais tous ces cœurs sont indépendants les uns des autres. Maintenant, lorsque nous avons un code qui peut être parallélisé, il serait bien d’avoir un certain nombre de cœurs qui font essentiellement la même chose et qui le font sans les frais généraux que nous obtenons lorsque chaque cœur est plutôt indépendant les uns des autres. C’est là qu’intervient la technologie de Flow et les cœurs PPU.

JK : Ainsi, à côté des cœurs de l’unité centrale standard, nous disposons d’un ensemble de cœurs qui font en grande partie la même chose à un moment donné et qui peuvent donc accélérer certains codes sans que chacun d’entre eux n’ait à récupérer son programme pour lui-même, car ils font tous la même chose. De plus, ils n’ont pas besoin de maintenir toutes les structures que les cœurs normaux de l’unité centrale doivent faire pour exécuter un programme. Nous disposons donc d’un moyen simple de paralléliser avec moins de frais généraux.

JK : De plus, les cœurs de PPU peuvent être plus petits qu’un cœur de CPU classique. Leur consommation d’énergie sera donc également plus faible.

Sources : Flow Computing

>> Découvrir le White Paper en PDF (Objectifs de conception, avantages et bénéfices du Flow Computing)