En observant leurs propres mouvements à l’aide d’une caméra, les robots peuvent apprendre à connaître la structure de leur propre corps et la manière dont ils se déplacent, révèle une nouvelle étude réalisée par des chercheurs de Columbia Engineering. Dotés de ces connaissances, les robots peuvent non seulement planifier leurs propres actions, mais aussi surmonter les dommages subis par leur corps.

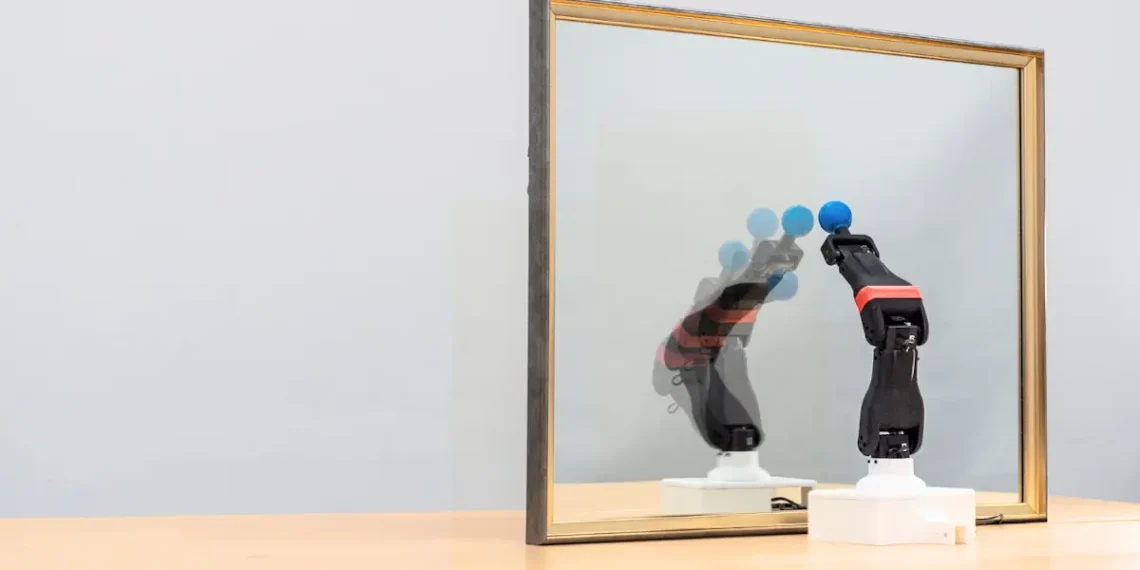

« À l’instar des humains qui apprennent à danser en regardant leur reflet dans le miroir, les robots utilisent désormais des vidéos brutes pour développer leur conscience cinématique », explique l’auteur principal de l’étude, Yuhang Hu, doctorant au Creative Machines Lab de l’université Columbia, dirigé par Hod Lipson, James and Sally Scapa Professor of Innovation et président du département d’ingénierie mécanique. « Notre objectif est de créer un robot qui comprenne son propre corps, s’adapte aux dommages et acquiert de nouvelles compétences sans avoir à être constamment programmé par l’homme. »

La plupart des robots apprennent d’abord à se déplacer dans des simulations. Une fois qu’un robot est capable de se déplacer dans ces environnements virtuels, il est relâché dans le monde physique où il peut continuer à apprendre. « Plus le simulateur est de qualité et réaliste, plus il est facile pour le robot de passer de la simulation à la réalité », indique M. Lipson.

Cependant, la création d’un bon simulateur est un processus ardu, qui requiert généralement des ingénieurs qualifiés. Les chercheurs ont appris à un robot à créer un simulateur de lui-même simplement en observant ses propres mouvements à l’aide d’une caméra. « Cette capacité permet non seulement d’économiser des efforts d’ingénierie, mais aussi de poursuivre la simulation et de la faire évoluer avec le robot au fur et à mesure qu’il subit l’usure, les dommages et l’adaptation », ajoute M. Lipson.

Dans la nouvelle étude, les chercheurs ont mis au point un moyen pour les robots de modéliser de manière autonome leurs propres formes en 3D à l’aide d’une seule caméra 2D ordinaire. Cette avancée a été réalisée grâce à trois systèmes d’IA imitant le cerveau, connus sous le nom de réseaux neuronaux profonds. Ceux-ci déduisent les mouvements en 3D à partir d’une vidéo en 2D, ce qui permet au robot de comprendre ses propres mouvements et de s’y adapter. Le nouveau système pourrait également identifier les altérations du corps des robots, comme la courbure d’un bras, et les aider à ajuster leurs mouvements pour se remettre de ces dommages simulés.

Une telle capacité d’adaptation pourrait s’avérer utile dans toute une série d’applications réelles. Par exemple, « imaginons un aspirateur robot ou un assistant personnel qui s’aperçoit que son bras est plié après avoir heurté un meuble », commente M. Hu. « Au lieu de tomber en panne ou d’avoir besoin d’être réparé, il se surveille, ajuste ses mouvements et continue à travailler. Cela pourrait rendre les robots domestiques plus fiables, sans qu’il soit nécessaire de les reprogrammer en permanence. »

Un autre scénario pourrait être celui d’un bras robotisé qui se désaligne dans une usine automobile. « Au lieu d’arrêter la production, il pourrait s’observer, modifier ses mouvements et reprendre ses travaux de soudage, ce qui réduirait les temps d’arrêt et les coûts », explique M. Hu. « Cette capacité d’adaptation pourrait rendre la fabrication plus résistante. »

Alors que nous confions de plus en plus de fonctions critiques aux robots, de la fabrication aux soins médicaux, nous avons besoin que ces robots soient plus résistants. « Nous, les humains, ne pouvons pas nous permettre de donner constamment des soins à ces robots, de réparer les pièces cassées et d’ajuster les performances. Les robots doivent apprendre à prendre soin d’eux-mêmes s’ils veulent devenir vraiment utiles », indique encore M. Lipson. « C’est pourquoi l’auto-modélisation est si importante. »

La capacité démontrée dans cette étude est la dernière d’une série de projets que l’équipe de Columbia a publiés au cours des deux dernières décennies, où les robots apprennent à mieux se modéliser eux-mêmes à l’aide de caméras et d’autres capteurs.

En 2006, les robots de l’équipe de recherche étaient capables d’utiliser des observations pour créer uniquement des simulations simples d’eux-mêmes, semblables à des figurines de bâton. Il y a une dizaine d’années, les robots ont commencé à créer des modèles plus fidèles à l’aide de plusieurs caméras. Dans cette étude, le robot a été capable de créer un modèle cinématique complet de lui-même en utilisant seulement un court clip vidéo provenant d’une seule caméra ordinaire, un peu comme s’il se regardait dans un miroir. Les chercheurs ont baptisé cette nouvelle capacité « conscience cinématique de soi ».

« Nous pouvons nous imaginer dans le futur et visualiser les conséquences de nos actions bien avant de les exécuter dans la réalité », conclut M. Lipson. « À terme, nous aimerions doter les robots d’une capacité similaire à s’imaginer, car une fois que l’on peut s’imaginer dans le futur, il n’y a plus de limite à ce que l’on peut faire. »

Légende illustration : Un robot observe son reflet dans un miroir, apprenant sa propre morphologie et sa cinématique pour une autosimulation autonome. Ce processus met en évidence l’intersection entre l’apprentissage basé sur la vision et la robotique, où le robot affine ses mouvements et prédit ses déplacements spatiaux grâce à l’auto-observation. Crédit : Jane Nisselson/Columbia Engineering

Article : « Teaching robots to build simulations of themselves » – DOI : 10.1038/s42256-025-01006-w

Source : Columbia Engineering – Traduction enerzine.com