Les applications d’IA telles que les grands modèles de langage (LLM) font désormais partie intégrante de notre vie quotidienne. Les capacités de calcul, de stockage et de transmission nécessaires sont fournies par des centres de données qui consomment de grandes quantités d’énergie. Rien qu’en Allemagne, cela représentait environ 16 milliards de kWh en 2020, soit environ 1 % de la consommation totale d’énergie du pays. En 2025, ce chiffre devrait atteindre 22 milliards de kWh.

Une nouvelle méthode 100 fois plus rapide pour une précision comparable

L’arrivée d’applications d’IA plus complexes dans les années à venir augmentera considérablement la demande de capacité des centres de données. Ces applications consommeront d’énormes quantités d’énergie pour l’entraînement des réseaux neuronaux. Pour contrer cette tendance, des chercheurs ont mis au point une méthode d’entraînement 100 fois plus rapide avec une précision comparable aux procédures existantes. Cela permettra de réduire considérablement la consommation d’énergie pour la formation.

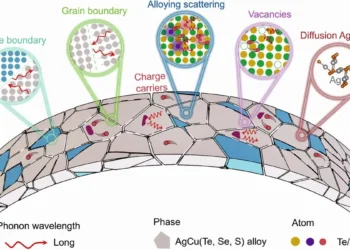

Le fonctionnement des réseaux neuronaux, qui sont utilisés en IA pour des tâches telles que la reconnaissance d’images ou le traitement du langage, s’inspire de celui du cerveau humain. Ces réseaux sont constitués de nœuds interconnectés appelés neurones artificiels. Les signaux d’entrée sont pondérés en fonction de certains paramètres, puis additionnés. Si un seuil défini est dépassé, le signal est transmis au nœud suivant. Pour former le réseau, la sélection initiale des valeurs des paramètres est généralement aléatoire, par exemple en utilisant une distribution normale. Les valeurs sont ensuite ajustées de manière incrémentale pour améliorer progressivement les prédictions du réseau. En raison des nombreuses itérations nécessaires, cette formation est extrêmement exigeante et consomme beaucoup d’électricité.

Des paramètres sélectionnés en fonction des probabilités

Felix Dietrich, professeur de Physics-enhanced Machine Learning, et son équipe ont développé une nouvelle méthode. Au lieu de déterminer itérativement les paramètres entre les nœuds, leur approche utilise des probabilités. Leur méthode probabiliste est basée sur l’utilisation ciblée de valeurs à des endroits critiques des données d’apprentissage où des changements de valeurs importants et rapides ont lieu. L’objectif de la présente étude est d’utiliser cette approche pour acquérir des systèmes dynamiques de conservation de l’énergie à partir des données. De tels systèmes changent au fil du temps selon certaines règles et sont présents dans les modèles climatiques et les marchés financiers, par exemple.

« Notre méthode permet de déterminer les paramètres requis avec une puissance de calcul minimale. Cela peut rendre l’entraînement des réseaux neuronaux beaucoup plus rapide et, par conséquent, plus économe en énergie », explique Felix Dietrich. « En outre, nous avons constaté que la précision de la nouvelle méthode est comparable à celle des réseaux formés de manière itérative. »

Légende illustration : Le SuperMUC-NG du Leibniz Supercomputing Centre est le huitième ordinateur le plus rapide au monde.

Rahma, Atamert, Chinmay Datar, et Felix Dietrich, « Training Hamiltonian Neural Networks without Backpropagation », 2024. Machine Learning and the Physical Sciences Workshop at the 38th conference on Neural Information Processing Systems (NeurIPS) neurips.cc/virtual/2024/99994